写给小白的大模子初学科普

序文:网上对于大模子的著述也好多,关联词齐不太容易看懂。小枣君今天试着写一篇,争取作念到阳春白雪。

空话未几说,咱们直入主题。

█ 什么是大模子?

大模子,英文名叫Large Model,大型模子。早期的时候,也叫Foundation Model,基础模子。

大模子是一个简称。无缺的叫法,应该是“东说念主工智能预查验大模子”。预查验,是一项工夫,咱们后头再评释。

咱们目下理论上常说的大模子,试验上专指大模子的其中一类,亦然用得最多的一类——谈话大模子(Large Language Model,也叫大谈话模子,简称LLM)。

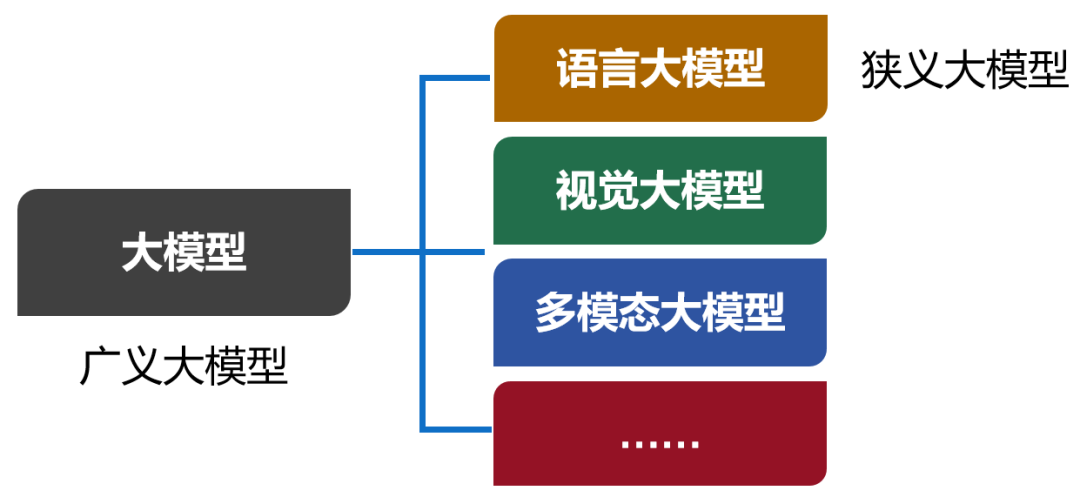

除了谈话大模子以外,还有视觉大模子、多模态大模子等。目下,包括所有这个词类别在内的大模子书籍,被称为广义的大模子。而谈话大模子,被称为狭义的大模子。

从试验来说,大模子,是包含超大规模参数(常常在十亿个以上)的神经汇注模子。

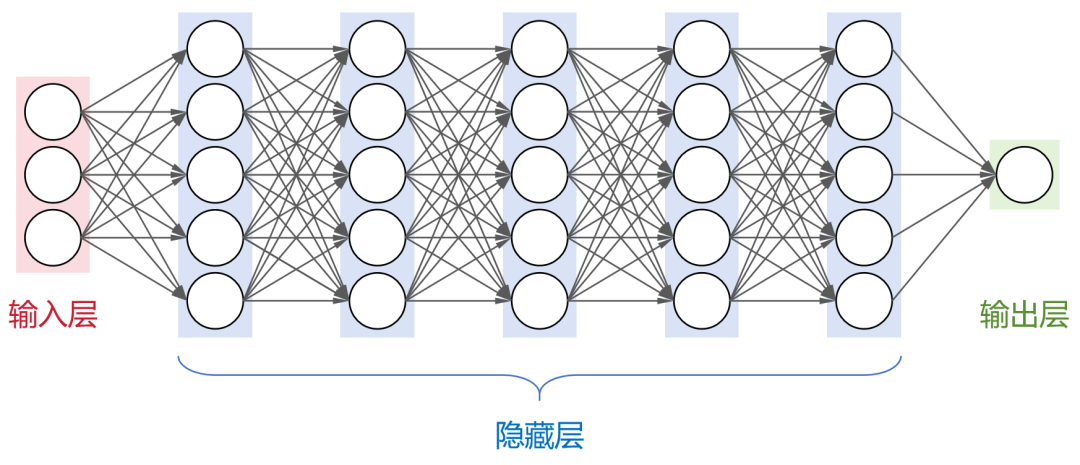

之前给众人科普东说念主工智能(蚁集)的时候,小枣君先容过,神经汇注是东说念主工智能规模目下最基础的筹议模子。它通过模拟大脑中神经元的攀附边幅,省略从输入数据中学习并生成有效的输出。

这是一个全攀附神经汇注(每层神经元与下一层的所有这个词神经元齐有攀附),包括1个输入层,N个避让层,1个输出层。

大名鼎鼎的卷积神经汇注(CNN)、轮回神经汇注(RNN)、是非时操心汇注(LSTM)以及transformer架构,齐属于神经汇注模子。

目下,业界大部分的大模子,齐承袭了transformer架构。

刚才提到,大模子包含了超大规模参数。试验上,大模子的“大”,不仅是参数规模大,还包括:架构规模大、查验数据大、算力需求大。

以OpenAI公司的GPT-3为例。这个大模子的避让层一共有96层,每层的神经元数目达到2048个。

通盘架构的规模就很大(我可画不出来),神经元节点数目好多。

大模子的参数数目和神经元节点数有一定的关系。简便来说,神经元节点数越多,参数也就越多。举例,GPT-3的参数数目,爽快是1750亿。

大模子的查验数据,也辱骂常普遍的。

同样以GPT-3为例,承袭了45TB的文本数据进行查验。即等于清洗之后,也有570GB。具体来说,包括CC数据集(4千亿词)+WebText2(190亿词)+BookCorpus(670亿词)+维基百科(30亿词),全齐堪称海量。

终末是算力需求。

这个众人应该齐传说过,查验大模子,需要多半的GPU算卡资源。而且,每次查验,齐需要很长的时间。

GPU算卡

证据公开的数据自大,查验GPT-3爽快需要3640PFLOP·天(PetaFLOP·Days)。淌若承袭512张英伟达的A100 GPU(单卡算力195 TFLOPS),爽快需要1个月的时间。查验过程中,巧合候还会出现中断,试验时间会更长。

一言以蔽之,大模子就是一个虚构的短小精悍,架构复杂、参数普遍、依赖海量数据,且高出烧钱。

比拟之下,参数较少(百万级以下)、层数较浅的模子,是小模子。小模子具有轻量级、高服从、易于部署等优点,适用于数据量较小、筹议资源有限的垂直规模场景。

█ 大模子是如何查验出来的?

接下来,咱们了解一下大模子的查验过程。

众人齐知说念,大模子不错通过对海量数据的学习,经受数据内部的“常识”。然后,再对常识进行期骗,举例回报问题、创造内容等。

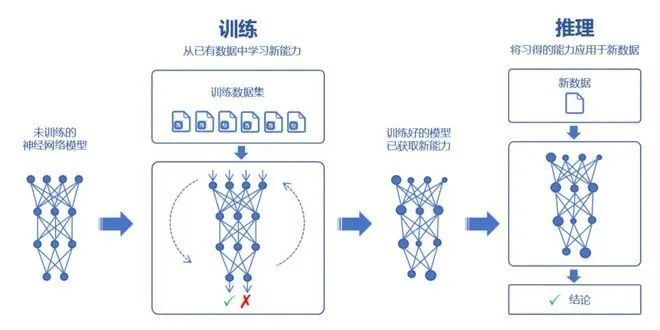

学习的过程,咱们称之为查验。期骗的过程,则称之为推理。

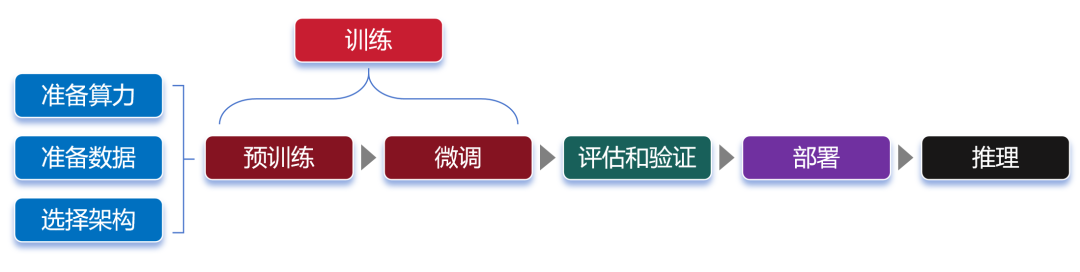

查验,又分为预查验(Pre-trained)和微调(Fine tuning)两个要领。

预查验

在预查验时,咱们率先要采用一个大模子框架,举例transformer。然后,通过“投喂”前边说的海量数据,让大模子学习到通用的特征示意。

那么,为什么大模子省略具有这样坚忍的学习才气?为什么说它的参数越多,学习才气就越强?

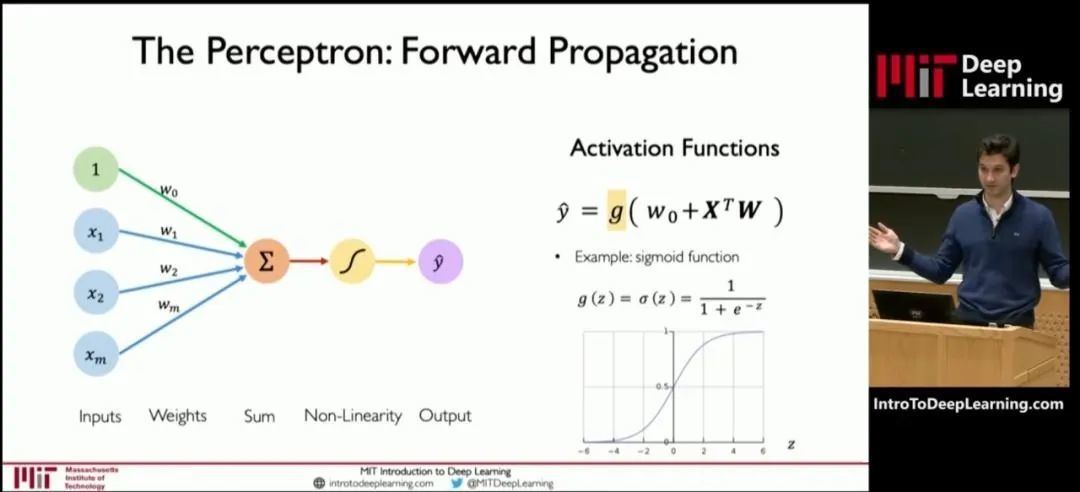

咱们不错参考MIT(麻省理工)公开课的一张图:

这张图是深度学习模子中一个神经元的结构图。

神经元的处理过程,其实就是一个函数筹议过程。算式中,x是输入,y是输出。预查验,就是通过x和y,求解W。W是算式中的“权重(weights)”。

权重决定了输入特征对模子输出的影响进程。通过反复查验来获取权重,这就是查验的兴味。

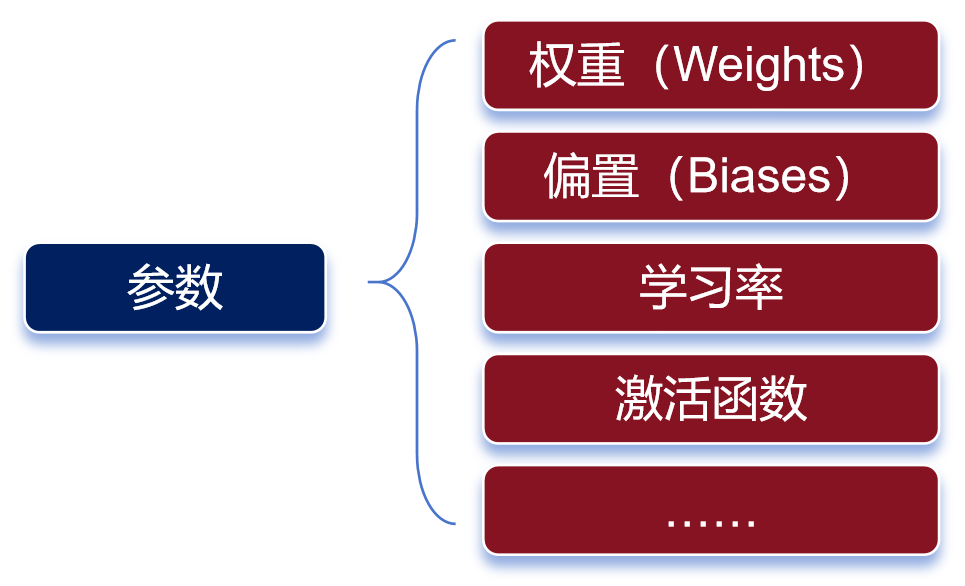

权重是最主要的参数类别之一。除了权重以外,还有另一个报复的参数类别——偏置(biases)。

参数有好多种类

权重决定了输入信号对神经元的影响进程,而偏置则不错瓦解为神经元的“容忍度”,即神经元对输入信号的明锐进程。

简便来说,预查验的过程,就是通过对数据的输入和输出,去反复“推算”最合理的权重和偏置(也就是参数)。查验完成后,这些参数会被保存,以便模子的后续使用或部署。

参数越多,模子常常省略学习到更复杂的理论和特征,从而在各式任务上阐明出更强的性能。

咱们常常会说大模子具有两个特征才气——败露才气和泛化才气。

当模子的查验数据和参数束缚扩大,直到达到一定的临界规模后,会阐明出一些未能料到的、更复杂的才气和特质。模子省略从原始查验数据中,自动学习并发现新的、更高等次的特征和理论。这种才气,被称为“败露才气”。

“败露才气”,不错瓦解为大模子的脑子倏得“开窍”了,不再只是是复述常识,而是省略瓦解常识,况且省略发散念念维。

泛化才气,是指大模子通过“投喂”海量数据,不错学习复杂的理论和特征,不错对未见过的数据作念出准确的料到。

简便来说,就像董宇辉一样,书读得多了,有些书天然没读过,他也能瞎扯几句。

参数规模越来越大,天然能让大模子变得更强,关联词也会带来更普遍的资源耗尽,致使可能增多“过拟合”的风险。

过拟合,是指模子对查验数据学习得过于精准,以至于它启动捕捉并响应查验数据中的噪声和细节,而不是数据的总体趋势或规章。说白了,就是大模子变成了“书呆子”,只会死记硬背,不肯意交融交融。

预查验所使用的数据,咱们也需要再说明一下。

预查验使用的数据,是海量的未标注数据(几十TB)。

之是以使用未标注数据,是因为互联网上存在多半的此类数据,很容易获取。而标注数据(基本上靠东说念主肉标注)需要耗尽多半的时间和财富,成本太高。

预查验模子,不错通过无监督学习递次(如自编码器、生成回击汇注、掩码谈话建模、对比学习等,众人不错另行了解),从未标注数据中,学习到数据的通用特征和示意。

这些数据,也不是歪邪网落魄载得来的。通盘数据需要经过网罗、清洗、脱敏和分类等过程。这样不错去除颠倒数据和作假数据,还能删除秘密数据,让数据愈加圭臬化,有意于后头的查验过程。

获取数据的边幅,亦然万般化的。

淌若是个东说念主和学术接头,不错通过一些官方论坛、开源数据库或者接头机构获取。淌若是企业,既不错自行网罗和处理,也不错径直通过外部渠说念(阛阓上有专诚的数据提供商)购买。

微调

预查验学习之后,咱们就得到了一个通用大模子。这种模子一般不行径直拿来用,因为它在完成特定任务时往往阐明欠安。

这时,股民咱们需要对模子进行微调。

微调,是给大模子提供特定规模的标注数据集,对预查验的模子参数进行轻微的调遣,让模子更好的完成特定任务。

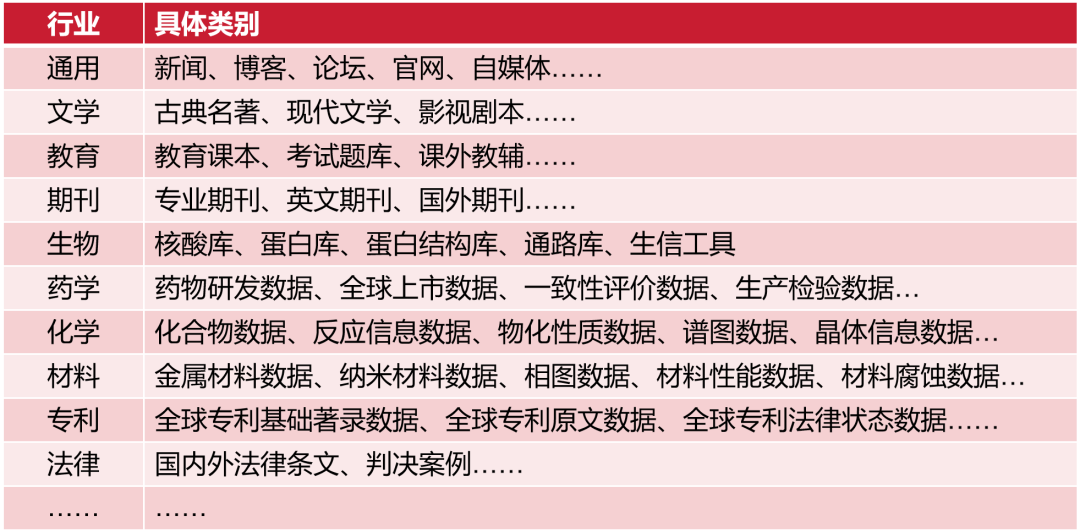

行业数据类别

微调之后的大模子,不错称之为行业大模子。举例,通过基于金融证券数据集的微调,不错得到一个金融证券大模子。

淌若再基于更细分的专科规模进行微调,就是专科大模子(也叫垂直大模子)。

咱们不错把通用大模子瓦解为中小学生,行业大模子是大学本科生,专科大模子是接头生。

微调阶段,由于数据量远小于预查验阶段,是以对算力需求小好多。

众人留神,对于大部分大模子厂商来说,他们一般只作念预查验,不作念微调。而对于行业客户来说,他们一般只作念微调,不作念预查验。

“预查验+微调”这种分阶段的大模子查验边幅,不错幸免相通的参加,细水长流多半的筹议资源,显贵擢升大模子的查验服从和收尾。

预查验和微调齐完成之后,需要对这个大模子进行评估。通过承袭试验数据或模拟场景对大模子进行评估考据,阐明大模子的性能、相识性和准确性等是否合适瞎想条目。

等评估和考据也完成,大模子基本上算是打形胜利了。接下来,咱们不错部署这个大模子,将它用于推理任务。

换句话说,这时候的大模子照旧“定型”,参数不再变化,不错真实启动干活了。

大模子的推理过程,就是咱们使用它的过程。通过发问、提供指示词(Prompt),不错让大模子回报咱们的问题,或者按条目进行内容生成。

终末,画一张无缺的经过图:

█ 大模子究竟有什么作用?

证据查验的数据类型和应用主义,咱们常常会将大模子分为谈话大模子(以文本数据进行查验)、音频大模子(以音频数据进行查验)、视觉大模子(以图像数据进行查验),以及多模态大模子(文本和图像齐有)。

谈话大模子,擅长天然谈话处理(NLP)规模,省略瓦解、生成和处理东说念主类谈话,常用于文本内容创作(生成著述、诗歌、代码)、文件分析、摘要汇总、机器翻译等场景。众人熟习的ChatGPT,就属于此类模子。

音频大模子,不错识别和坐蓐语音内容,常用于语音助手、语音客服、智能家居语音限定等场景。

视觉大模子,擅长筹议机视觉(CV)规模,不错识别、生成致使建立图像,常用于安防监控、自动驾驶、医学以及天文图像分析等场景。

多模态大模子,结合了NLP和CV的才气,通过整并吞处理来自不同模态的信息(文本、图像、音频和视频等),不错处理跨规模的任务,举例文生图,文生视频、跨媒体搜索(通过上传图,搜索和图干系的笔墨刻画)等。

本年以来,多模态大模子的崛起势头高出彰着,照旧成为行业关注的焦点。

淌若按照拂用场景进行分类,那么类别就更多了,举例金融大模子、医疗大模子、法律大模子、西席大模子、代码大模子、动力大模子、政务大模子、通讯大模子,等等。

举例金融大模子,不错用于风险料理、信用评估、交游监控、阛阓料到、公约审查、客户行状等。功能和作用好多好多,不再赘述。

█ 大模子的发展趋势?

限定2024年3月25日,中国10亿参数规模以上的大模子数目照旧越过100个,堪称“百模大战”。

这些大模子的应用规模、参数规模各有不同,关联词,背后齐是白茫茫的银子。

证据行业估测的数据,查验一个大模子,成本可能在几百万好意思元到上亿好意思元之间。举例,GPT-3查验一次的成本,约为140万好意思元。Claude 3模子的查验用度,高达约1亿好意思元。

如斯多的企业推出大模子,试验上亦然一种资源的迫害。

而且,大模子也分为开源大模子和闭源大模子。行业里有才气作念闭源大模子的企业,并不是好多。大部分的大模子,齐是基于开源大模子框架和工夫打造的,试验上是为了投合本钱阛阓的需求,或者为了蹭热度。

行业里,目下仍有部分头部企业在死磕参数规模更大的超大模子(领少见万亿到数千万亿个参数),举例OpenAI、xAI等。马斯克之前就在X平台告示,xAI团队照旧胜利启动了寰宇上最坚忍的AI查验集群。该集群由10万块H100构成,主要用于Grok 2和Grok 3的查验和开发。

对于大部分企业来说,万卡和万亿参数其实照旧是个天花板了,再往上走的意愿不利害,钱包也不允许。

跟着行业迟缓趋于感性,目下众人的关注焦点,迟缓从“打造大模子”,变成“使用大模子”。如何将大模子参加具体应用,如何诱骗更多用户,如何通过大模子创造收入,成为各大厂商的头等任务。

大模子落地,就触及到才气“入”端(下千里到终局)。是以,AI手机、AI PC、具身智能的看法越来越火,成为新的发展热门。

以AI手机为例,像高通、联发科等芯片厂商,齐推出了具有更强AI算力的手机芯片。而OPPO、vivo等手机厂商,也在手机里内置了大模子,并推出了好多原生AI应用。

第三方AI应用的数目,就更毋庸说了。截止目下,证据行业数据自大,具有AI功能的APP数目已达到300多万款。2024年6月,AIGC类APP的月活跃用户规模达6170万,同比增长653%。

大模子入端,也带来了轻量化的趋势。为了在资源受限的开垦上运行,大模子将通过剪枝、量化、蒸馏等工夫进行轻量化,保执性能的同期减少筹议资源需求。

█ 大模子会带来哪些挑战?

大模子是一个好东西,省略帮咱们作念好多事情,省俭时间,擢升服从。关联词,大模子亦然一把双刃剑,会带来一些新的挑战。

率先,是影响自在率。大模子所掀翻的AI东说念主工智能波浪,笃定会导致一些东说念主类使命岗亭被替代,进而导致自在率上涨。

其次,是版权问题。大模子基于已少见据进行学习。大模子生成的内容,尤其是用于文本、图像、音乐和视频创作,可能激发版权和常识产权问题。它天然匡助了创作,但也“援用”了东说念主类创作家的作品,界限难以分裂。遥遥无期,可能打击东说念主类的原生创作关注。

第三,大模子可能激发算法偏见和不公说念。也就是说,查验数据中存在的偏差,会导致大模子学习到这些偏差,从而在料到和生成内容时阐明出不公说念的步履。模子可能意外中强化社会上的刻板印象和偏见,举例性别、种族和宗教等方面的偏见。大模子生成的内容也可能被用于政事宣传和主管,影响选举和全球公论。

第四,被用于违纪。大模子不错生成传神的文本、图像、语音和视频,这些内容可能被用于乱来、指责、伪善信息传播等坏心用途。

第五,能耗问题。大模子的查验和推理需要多半的筹议资源,这不仅增多了成本,还带来了巨大的碳排放。好多企业为了行状于本钱阛阓或跟风,盲目进行大模子查验,耗尽了多半的资源,也导致了无兴味的碳排放。

一言以蔽之,大模子在伦理、法律、社会和经济层面带来的胁迫和挑战照旧好多的,需要更多时间进行探索和贬责。

好啦,以上就是今天著述的一齐内容,但愿对众人有所匡助!